- Přehledy IS

- APS (20)

- BPM - procesní řízení (23)

- Cloud computing (IaaS) (10)

- Cloud computing (SaaS) (33)

- CRM (51)

- DMS/ECM - správa dokumentů (20)

- EAM (17)

- Ekonomické systémy (68)

- ERP (77)

- HRM (28)

- ITSM (6)

- MES (32)

- Řízení výroby (36)

- WMS (29)

- Dodavatelé IT služeb a řešení

- Datová centra (25)

- Dodavatelé CAD/CAM/PLM/BIM... (39)

- Dodavatelé CRM (33)

- Dodavatelé DW-BI (50)

- Dodavatelé ERP (71)

- Informační bezpečnost (50)

- IT řešení pro logistiku (45)

- IT řešení pro stavebnictví (26)

- Řešení pro veřejný a státní sektor (27)

ERP systémy

ERP systémy CRM systémy

CRM systémy Plánování a řízení výroby

Plánování a řízení výroby AI a Business Intelligence

AI a Business Intelligence DMS/ECM - Správa dokumentů

DMS/ECM - Správa dokumentů HRM/HCM - Řízení lidských zdrojů

HRM/HCM - Řízení lidských zdrojů EAM/CMMS - Správa majetku a údržby

EAM/CMMS - Správa majetku a údržby Účetní a ekonomické systémy

Účetní a ekonomické systémy ITSM (ITIL) - Řízení IT

ITSM (ITIL) - Řízení IT Cloud a virtualizace IT

Cloud a virtualizace IT IT Security

IT Security Logistika, řízení skladů, WMS

Logistika, řízení skladů, WMS IT právo

IT právo GIS - geografické informační systémy

GIS - geografické informační systémy Projektové řízení

Projektové řízení Trendy ICT

Trendy ICT E-commerce B2B/B2C

E-commerce B2B/B2C CAD/CAM/CAE/PLM/3D tisk

CAD/CAM/CAE/PLM/3D tisk | Přihlaste se k odběru zpravodaje SystemNEWS na LinkedIn, který každý týden přináší výběr článků z oblasti podnikové informatiky | |

| ||

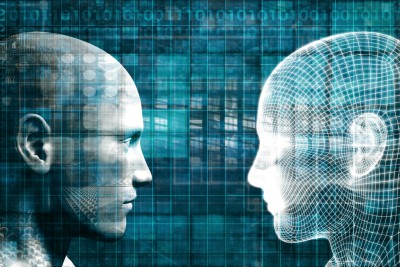

Accenture se snaží, aby systémy umělé inteligence byly etické a společensky korektní

Společnost Accenture vytvořila nový nástroj AI Fairness pro podporu etického jednání při zavádění umělé inteligence a strojového učení. Nástroj pomůže identifikovat a napravit chování algoritmů umělé inteligence (AI – Artifical Intelligence), které je v rozporu s aktuálními společenskými i právními standardy. Cílem je zachytit diskriminaci, které by se jinak mohla umělá inteligence dopustit a způsobit tak škodu.

Společnost Accenture vytvořila nový nástroj AI Fairness pro podporu etického jednání při zavádění umělé inteligence a strojového učení. Nástroj pomůže identifikovat a napravit chování algoritmů umělé inteligence (AI – Artifical Intelligence), které je v rozporu s aktuálními společenskými i právními standardy. Cílem je zachytit diskriminaci, které by se jinak mohla umělá inteligence dopustit a způsobit tak škodu.

Počítačové algoritmy se dostávají do role, kdy v prvním sítu rozhodují o řadě záležitostí – dělají jakýsi předvýběr, který předkládají k dořešení „lidským“ kolegům. A tak umělá inteligence může rozhodovat o tom, zda určitý člověk dostane půjčku, nabídku zaměstnání, případně povolení k určité činnosti. Umělá inteligence přitom může dojít k závěrům, které jsou považovány za diskriminační. Společnost Accenture se proto rozhodla vytvořit nástroj, který vyhodnocuje, zda systémy AI rozhodují v souladu s aktuálními společenskými i právními standardy.

Nástroj AI Fairness například hledá skryté citlivé proměnné, které podle současných etických pravidel není možno využít při rozhodování. Přestože by tak například algoritmus umělé inteligence nemusel explicitně zohledňovat pohlaví, pokud se podívá na příjem, mohl by snadno oddělit výsledky pro ženy a muže. Nástroj AI Fairness je schopen tento algoritmus opravit, ale protože tento typ korekce může způsobit snížení jeho přesnosti, navrhne řešení a umožní uživateli rozhodnout, nakolik se má změnit.

„V minulosti jsme našli modely, které jsou celkově velmi přesné, ale pokud se podíváte, jak se určitá chyba rozkládá nad podskupinami, uvidíte obrovský rozdíl mezi tím, jak správný je určitý model například pro bílého muže ve srovnání s černou ženou.“ říká Rumman Chowdhury, lídr v oblasti umělé inteligence společnosti Accenture.

„Vidíme rostoucí zaměření na algoritmické zkreslení a spravedlnost. Řada států vytváří etické rady AI, Google nedávno vydal své etické pokyny,“ konstatuje Rumman Chowdhury. „Takže si myslím, že lídři v oboru AI, stejně jako non-tech společnosti, hledají cestu. Hledají standardy a protokoly a něco, čím se mohou řídit, protože chtějí vytvářet a využívat bezpečné produkty.“

Umělá inteligence sama o sobě nemůže být spravedlivá nebo nespravedlivá, ovšem algoritmy, které pro rozhodování využívá, mohou kodifikovat nesprávné lidské chápání. Nový nástroj je určen společnostem, které chtějí rozšířit své používání AI, ale obávají se rizika neúmyslných dopadů. Předpokládá se, že prvními uživateli budou ti, kteří se nacházejí v nejvíce regulovaných oborech - například finančních služeb a zdravotní péče, kde je potenciál nežádoucích dopadů AI velký.

| Po | Út | St | Čt | Pá | So | Ne |

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 | 1 |

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

Formulář pro přidání akce